梯度下降法核心公式简单修改了一下,theta -= eta * gradient结果运行结果出乎意料

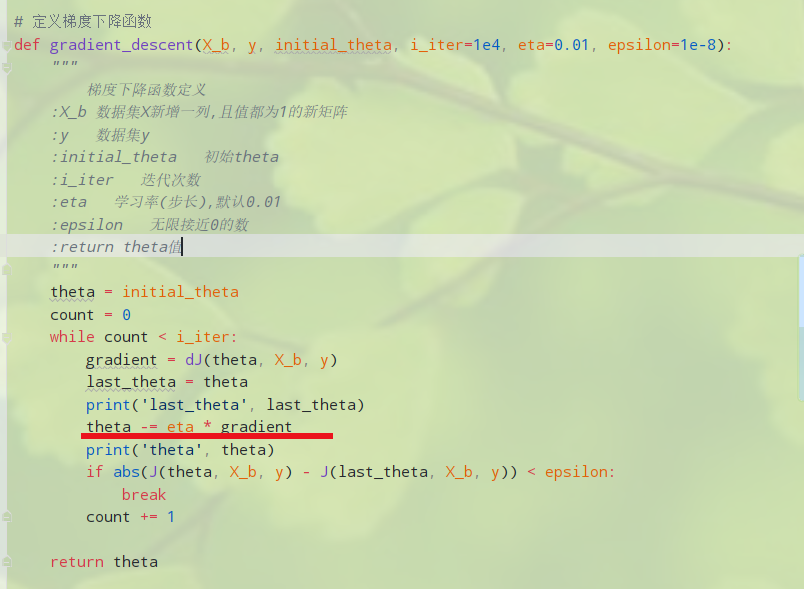

老师,在实现梯度下降法时,我自己修改了下代码:

将 theta = theta - eta * gradient 改为了theta -= eta * gradient

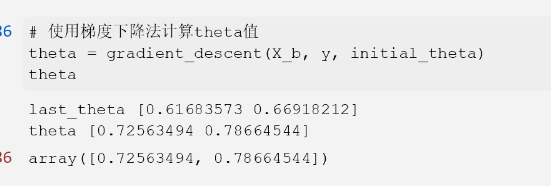

运行结果:

结果并不是想象中数据.

断点时,代码只执行1次就跳出循环了

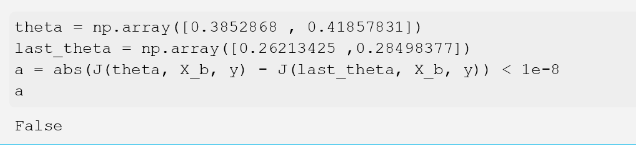

然后自己构造了数据去测试,发现并不满足 if 条件:

纠结好一会了,bobo老师帮忙看一下.

1207

收起