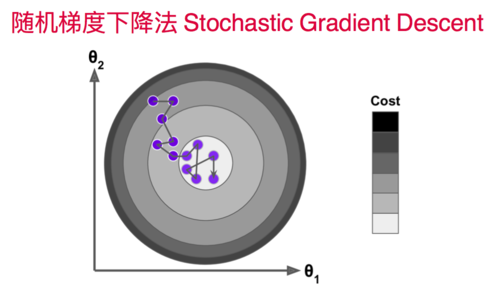

该怎么理解随机梯度必然会下降这个操作?

for i in range(m):

gradient = dJ_sgd(theta, X_b_new[i], y_new[i])

theta = theta - learning_rate(cur_iter * m + i)

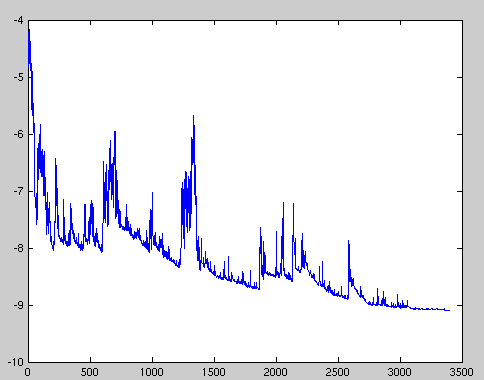

将样本地址随机后,对每一个样本做循环,求出随机梯度后,乘以不断减小的单位小量,对theta做减法,使theta不断向梯度的负方向(反方向)前进。

1985

收起

正在回答

1回答

相似问题

登录后可查看更多问答,登录/注册