梯度下降法和梯度上升法的收敛情况

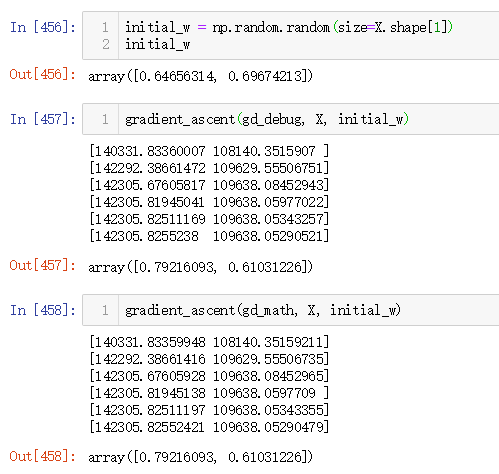

波波老师,我想问下,就是梯度下降法和梯度上升法,最终迭代后梯度是不是都会趋向于0?还是说两者的情况不一样。我自己就2维和3维上的感觉而言,迭代到最后找到的最小值(最大值),它在代价函数上的相应梯度都应该接近0才对。那本节课里面使用的梯度上升法,迭代到最后得到最大值结束的那几个几个梯度都是挺大的。

造成这样的情况是不是单位化w的原因?还是说,我本身对迭代到最后梯度应该趋向于0的理解有问题?

2033

收起