部署项目

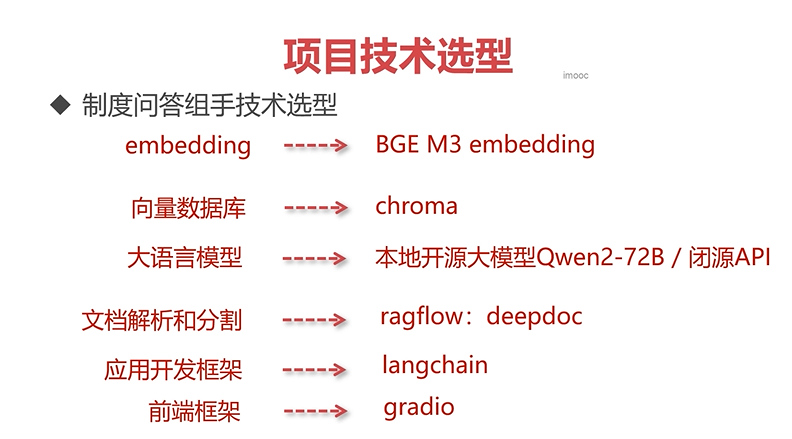

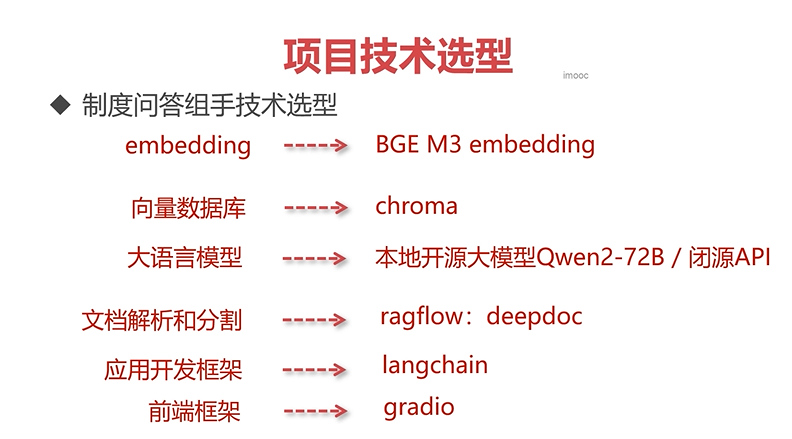

老师,您好!我想用这套技术搭建一个中小型的企业,制度问系统,在没有硬件服务器资源的情况,可以用这技术部署在云服务器上吗?采用什么云服务器好呢,采用什么云服务器配置,保证这个系统能应付200个并发提问。劳烦老师指导。

398

收起

老师,您好!我想用这套技术搭建一个中小型的企业,制度问系统,在没有硬件服务器资源的情况,可以用这技术部署在云服务器上吗?采用什么云服务器好呢,采用什么云服务器配置,保证这个系统能应付200个并发提问。劳烦老师指导。