如何控制爬虫爬取的速度

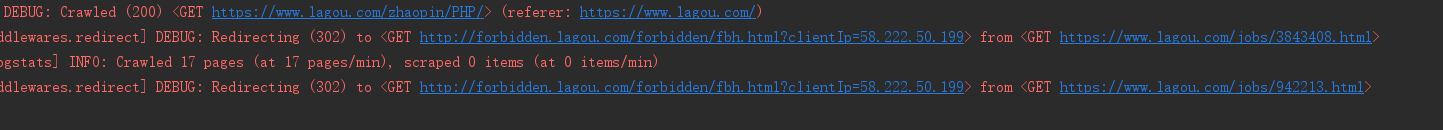

爬取拉钩的时候总会被判定为爬虫,我在setting文件下设置了

DOWNLOAD_DELAY = 3

感觉已经非常慢了,依然出现爬去职位详情页的时候被判定为爬虫。

1、除了在setting中设置DOWNLOAD_DELAY外还有什么方式控制速度呢?

2、是不是其他某些方面没有注意到被判定为爬虫呢?

2433

收起

正在回答

1回答

Scrapy打造搜索引擎 畅销4年的Python分布式爬虫课

- 参与学习 5831 人

- 解答问题 6293 个

带你彻底掌握Scrapy,用Django+Elasticsearch搭建搜索引擎

了解课程