两个或两个以上的网站爬取算是分布式爬虫吗? 我这样写可以启动无数个爬虫程序吧?为啥启动完第一个就直接结束了呢?

问题一:两个或两个以上的网站爬取算是分布式爬虫吗?

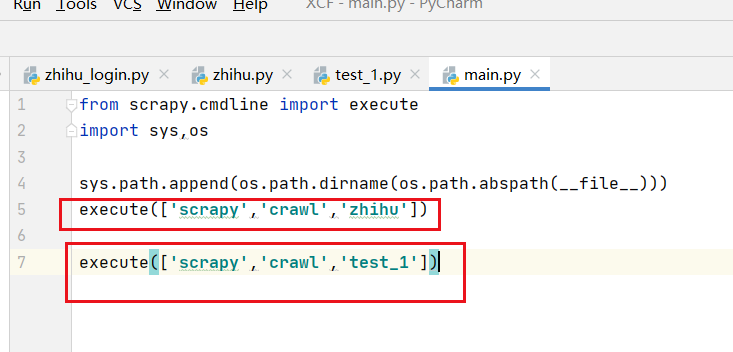

问题二:我这样写可以启动无数个爬虫程序吧?

问题三:为啥启动完第一个就直接结束了呢?

问题四:那有没有办法解决呀,或是要怎么样代码才能实现同时爬取10个,20个网站呢?

1270

收起

正在回答 回答被采纳积分+3

1回答

Scrapy打造搜索引擎 畅销4年的Python分布式爬虫课

- 参与学习 5831 人

- 解答问题 6293 个

带你彻底掌握Scrapy,用Django+Elasticsearch搭建搜索引擎

了解课程