Spark并行与资源分配的问题

讲师好,

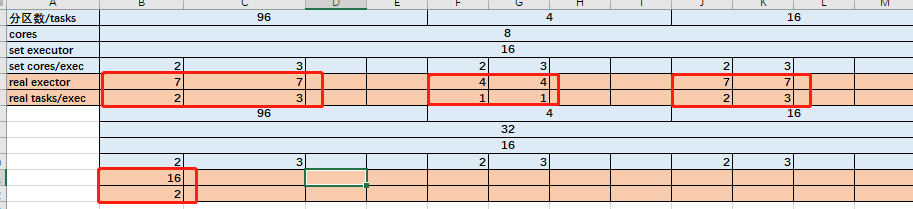

我这边试了一下。分区数,executor num,cores。决定executor和并行数的规则。

executor的个数为三者中最小的那个。

若分区数最少,并行数为1*分区数。

否则,并行数为executor.cores *executor。

不知道这个总结是否正确?

另外还有两个问题

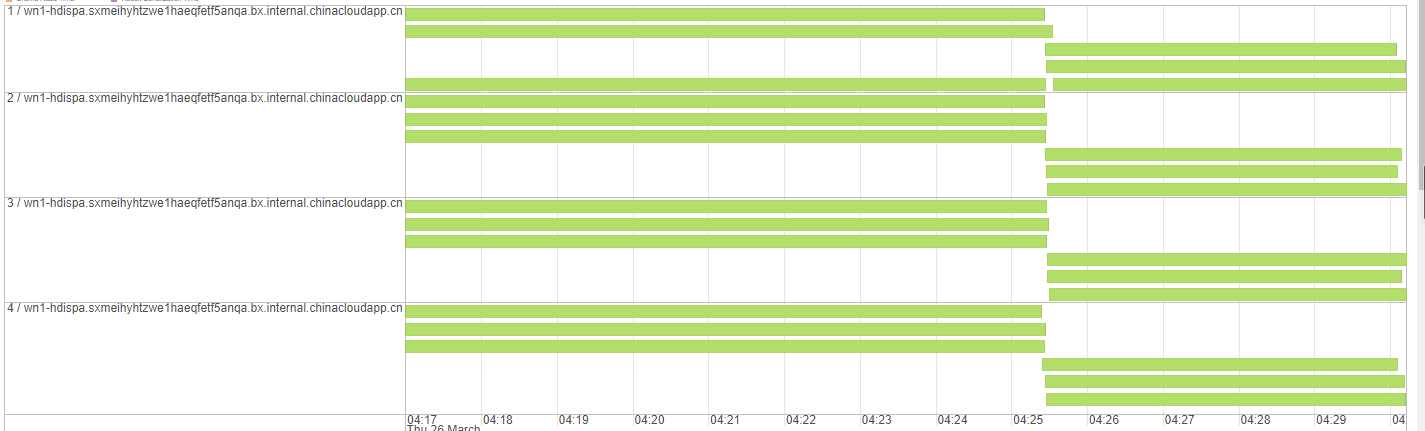

1.当我的worknode 只有1个,为8Cores,且分区为24。我设置了executor num=4,executor.cores=3。Stage中看到12个并行,而且Executors显示的为12Cores。请问这个8cores是自己分为12份的吗。

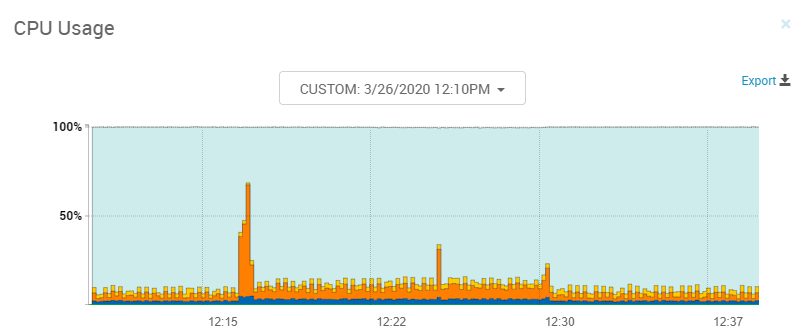

2.ambari 我看到的CPU占用率并不高。我向请问并行程序和CPU 占用率 之间的关系是什么?WorkerNode如下,不知道头节点的需不需要看。

1458

收起