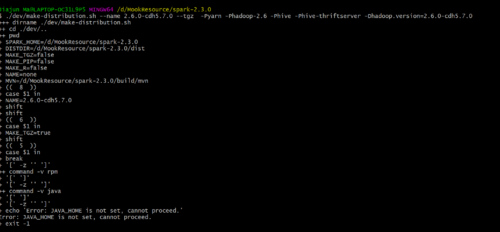

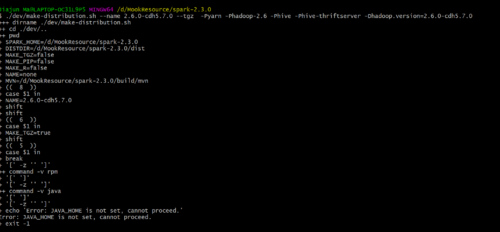

spark在本机上的编译问题

输入正文 老师,我在本机上编译spark,但是总是报错,说java_home没有配置,要怎么修改呢?因为希望老师可以回复一下,因为要在本机的pycharm里面导入spark

老师,我在本机上编译spark,但是总是报错,说java_home没有配置,要怎么修改呢?因为希望老师可以回复一下,因为要在本机的pycharm里面导入spark

1194

收起

输入正文 老师,我在本机上编译spark,但是总是报错,说java_home没有配置,要怎么修改呢?因为希望老师可以回复一下,因为要在本机的pycharm里面导入spark

老师,我在本机上编译spark,但是总是报错,说java_home没有配置,要怎么修改呢?因为希望老师可以回复一下,因为要在本机的pycharm里面导入spark