lstm实现,num_lstm_nodes与num_time_step含义理解、与实现x_size,h_size维度的理解

老师,您好,我还是有点疑惑。

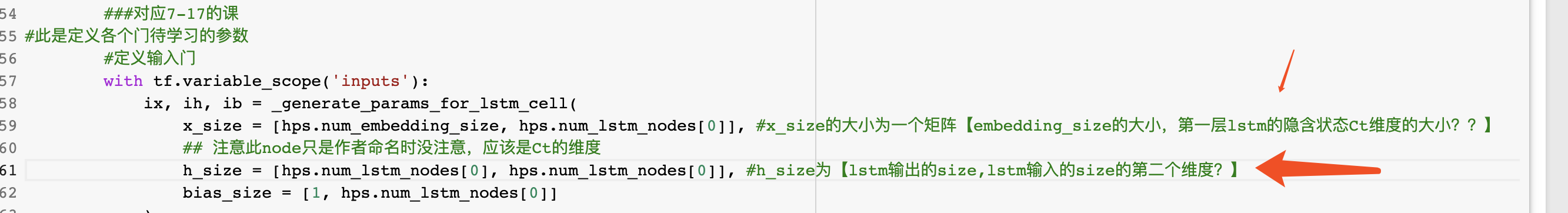

7-17视频,text-rnn-pure-lstm.ipynb代码中

1)看到您在其他答疑下游解释"num_lstm_nodes的含义跟全连接层的num_units类似,就是LSTM内部状态向量的长度",这里的内部状态向量长度和定义的“num_time_steps”不是一个概念吧?假设num_lstm_nodes[0]=32,num_time_steps=50,是说当num_time_steps=1,第一个时间序列时,经过的第一层lstm内部就有32个神经元来计算它的输出?

2)关于lstm实现的x_size 与h_size 的理解还是有些困惑,需要请教下您。

这里的x_size的第二个维度num_lstm_nodes[0]是lstm隐含状态的维度大小?

1696

收起