准确率结果相同时,不同超参数值的选择偏向

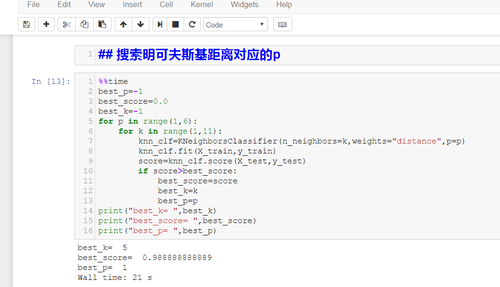

在第4-5课程中,搜索明科斯基距离相应的p时,由于我的算法与老师的略有不同,如下图,因best参数更新在于当前分数大于最好分数,则其只记录一组最好分数的记录

则 当最好分数为0.988888888889存在多组记录,如 我的bset_p=1,best_k=5 而老师的是bset_p=2,best_k=3

那么带来的问题是对于这两种结果一样,但参数数值不同的超参数应该怎么选取,应系统考虑哪些条件?(算法运行时间?)

1110

收起