spark-shell中执行sparkSQL报错:需要Hive支持

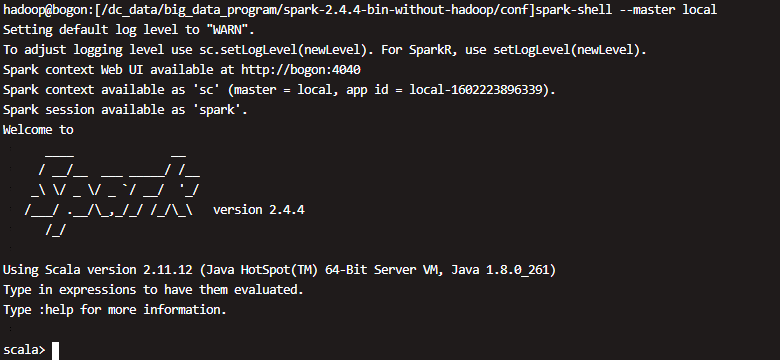

spark-shell启动正常

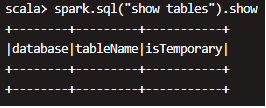

spark-shell执行spark.sql(“show tables”).show正常

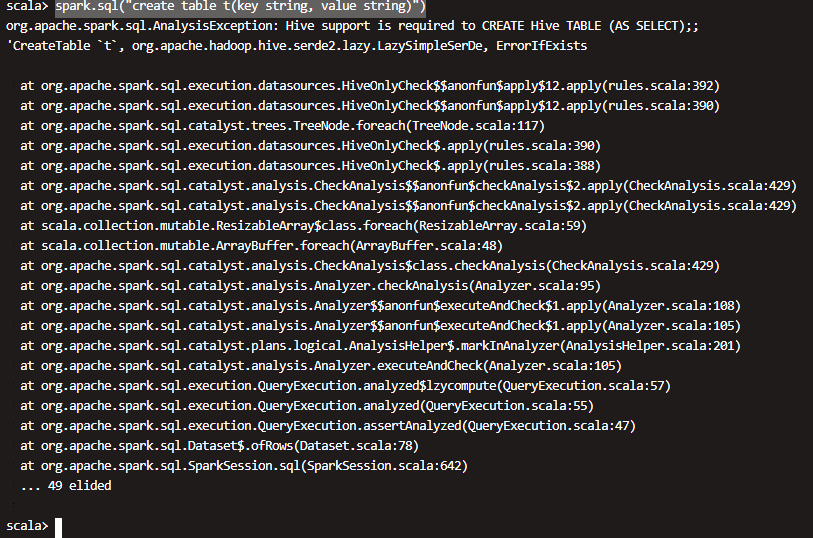

执行spark.sql(“create table t(key string, value string)”)报错

说是需要hive支持,我将hive-site.xml放入$SPARK_HOME/conf下依然不管用,我也启动了元数据共享nohup hive --service metastore &依然不行

1979

收起