pyspark可以访问hive但spark-submit访问不了hive

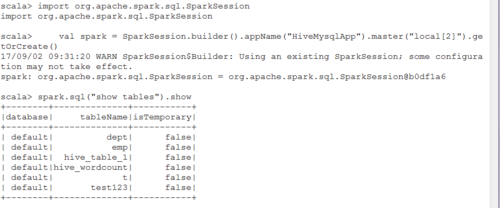

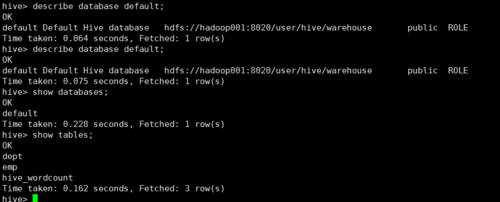

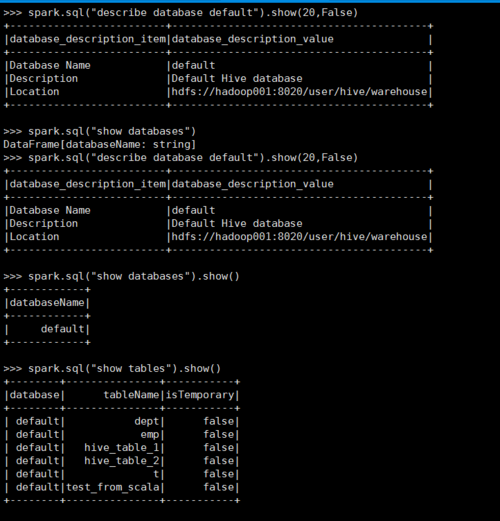

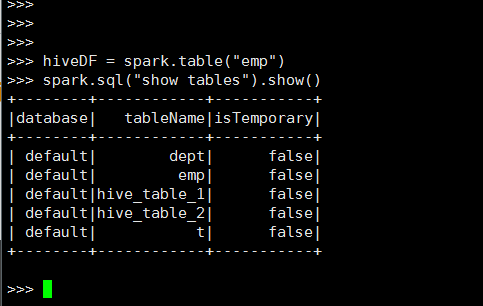

在pyspark中,可以正常连接并访问hive的数据

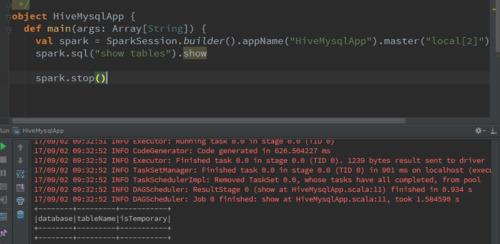

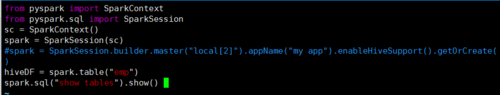

但是使用spark-submit时,代码如下:

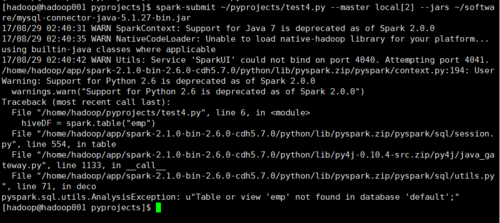

会报错:Table or view 'emp' not found in database 'default

按照网上搜索到的,使用了spark = SparkSession.builder.master("local[2]").appName("my app").enableHiveSupport().getOrCreate()之后,依然有如上报错。请问该如何解决?

(网上也有使用HiveContext的方法,但是HiveContext已经不被提倡了,并且我也使用这种方法尝试,还是不能正常连接。)

1799

收起