多页面爬取时,如何设置阈值,超过后先进行下载?

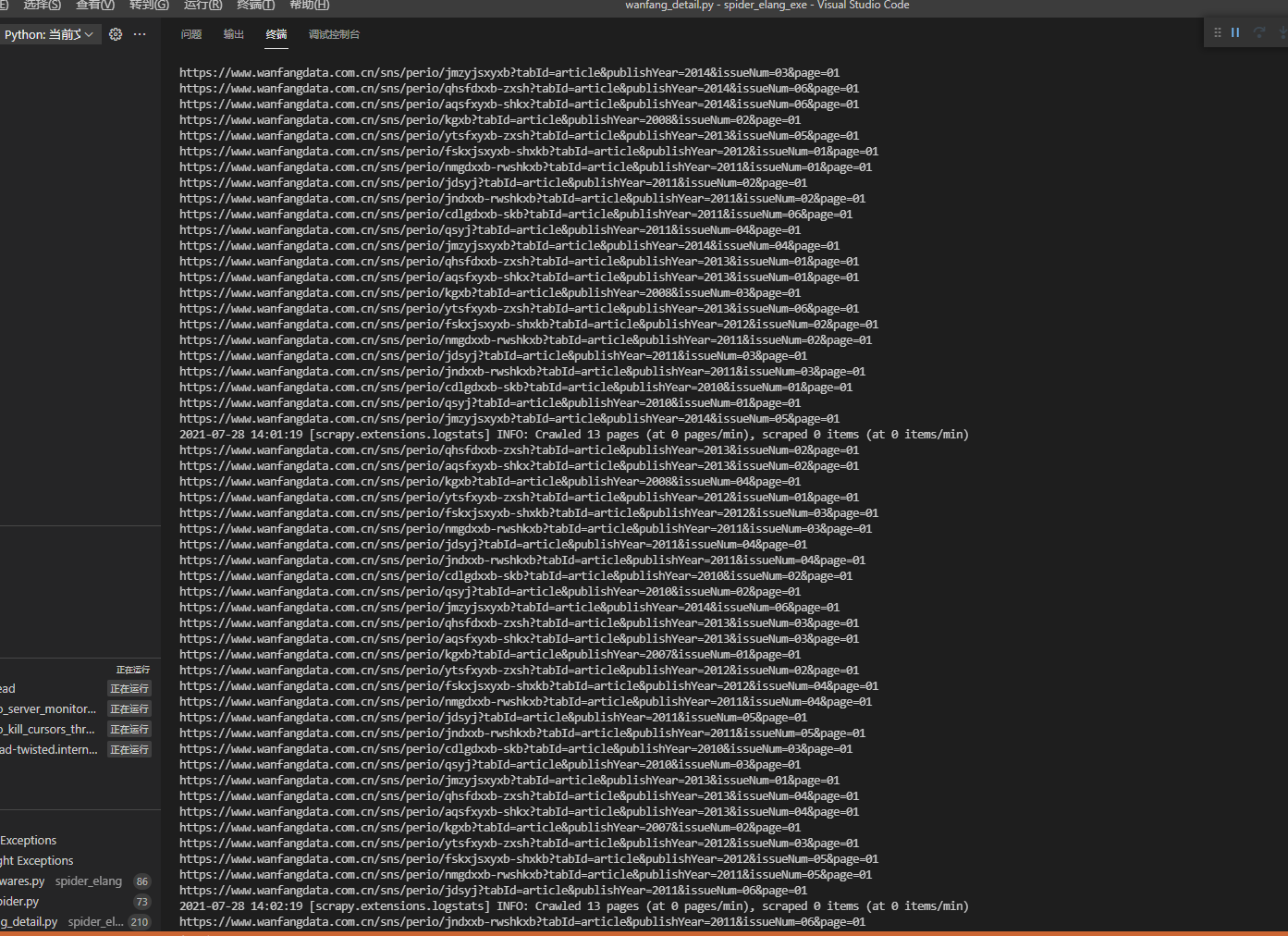

我在做测试时,爬取了一个多页面的网站,页面的链接我已经事先抓取到存储入库了,然后抓取数据的时候,读数据库就行。但是我是写在一个死循环里面,不断从数据库取数据,直到全部去完。

while True:

if self.count == self.total_count:

print("download over")

data = self.reload_cursor(self.count)

base_url = "https://www.xxx.info"

code = str(data["journal_link"]).split('/')[-1]

url = base_url + code

meta = {

"journal_code": code,

"baseid": data["baseid"],

"journal_img": data["journal_img"],

"journal_link": data["journal_link"]

}

yield scrapy.Request(url, dont_filter=True, meta=meta)

但是他就一直在那里抓取页面链接,死活跳转不到下载的程序那里。

就想问下,怎么能给他设置个值,比如说爬取50个页面或者100个,先不爬了,先下载数据,抓取详情,数据入库。弄完了再爬取新页面

637

收起

正在回答 回答被采纳积分+3

1回答

Scrapy打造搜索引擎 畅销4年的Python分布式爬虫课

- 参与学习 5831 人

- 解答问题 6293 个

带你彻底掌握Scrapy,用Django+Elasticsearch搭建搜索引擎

了解课程