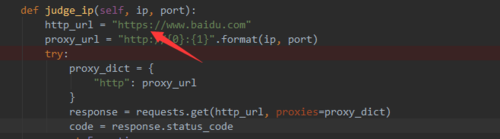

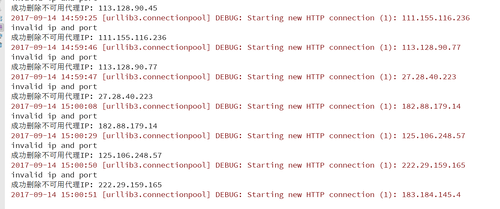

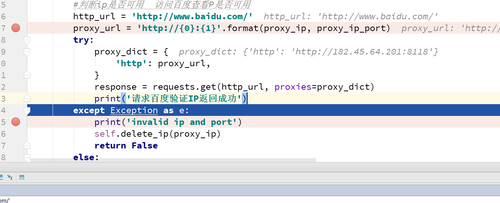

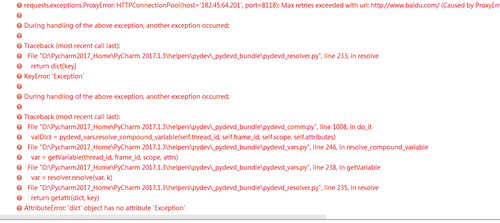

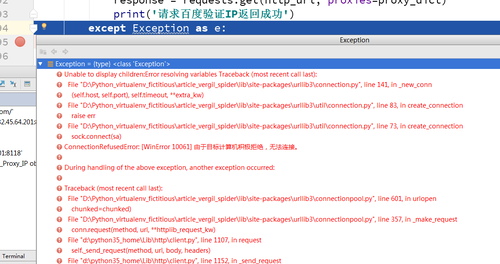

请求百度验证IP是否可用,一直有exception 截屏

debug 运行了几次都是 invalid ip and port 感觉代码没有问题,好像请求百度是不是失败了?

985

收起

正在回答 回答被采纳积分+3

5回答

Scrapy打造搜索引擎 畅销4年的Python分布式爬虫课

- 参与学习 5831 人

- 解答问题 6293 个

带你彻底掌握Scrapy,用Django+Elasticsearch搭建搜索引擎

了解课程