关于filtered duplicate request的疑惑?

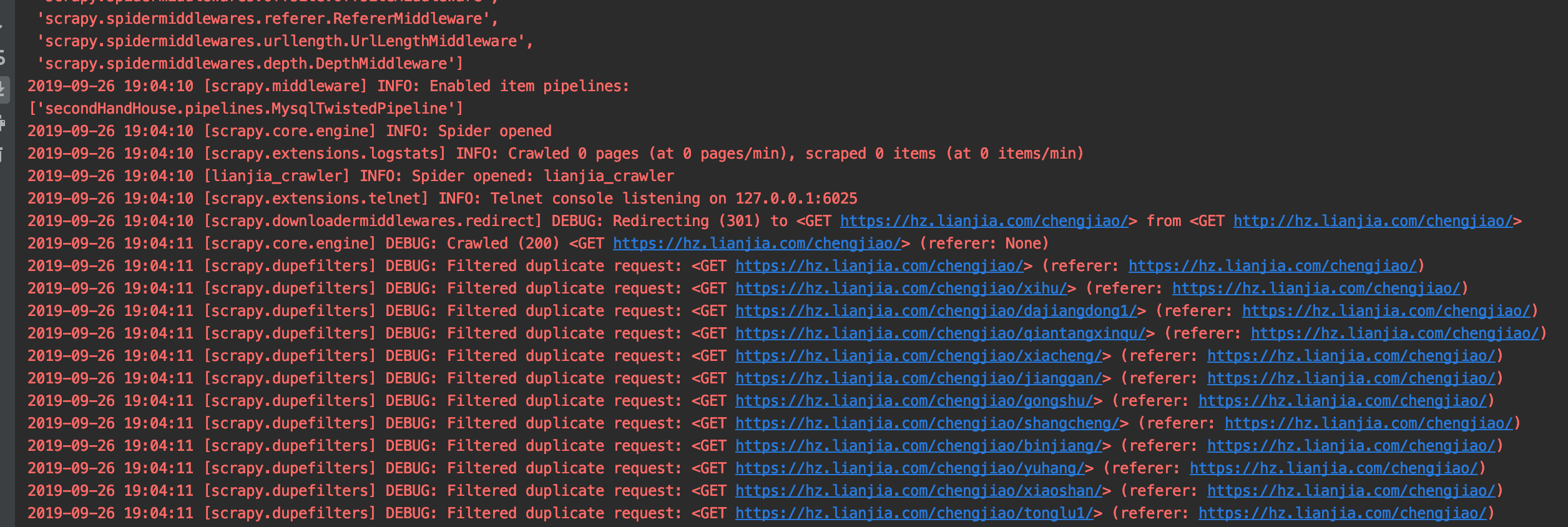

老师,下面日志中这个filtered duplicate request让我很疑惑:

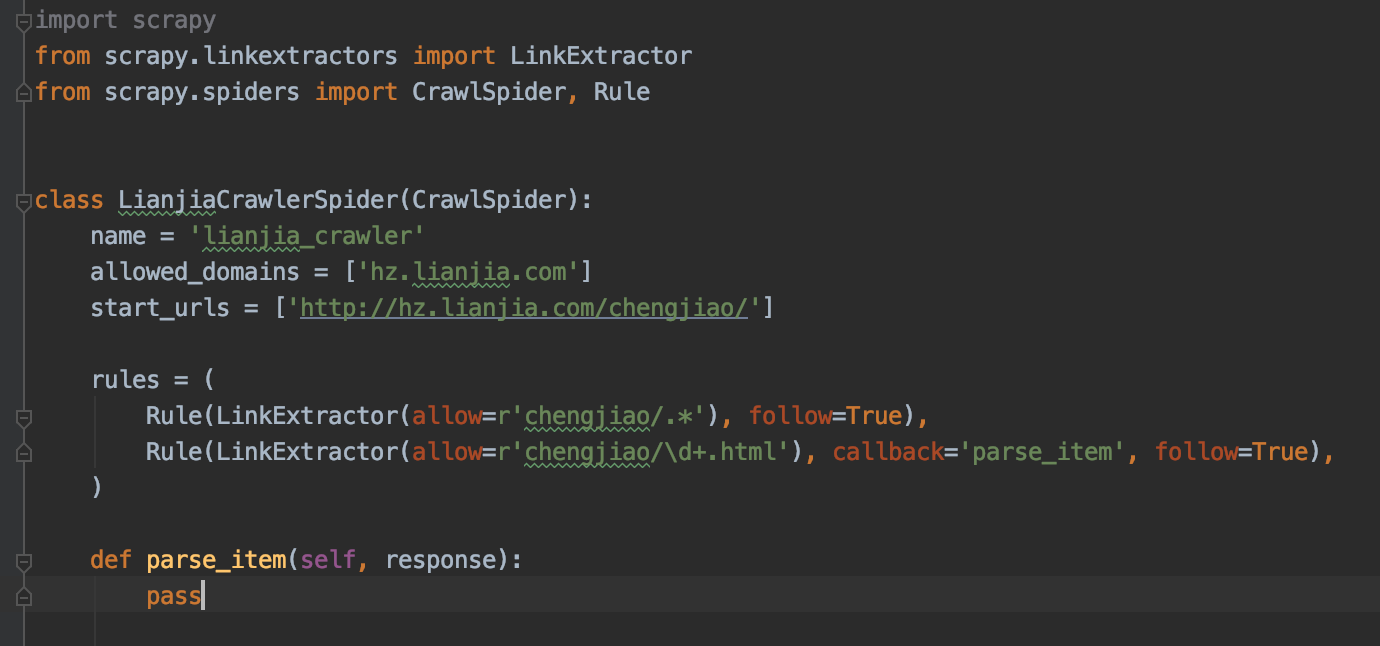

这些request看上去像是在 dont_filter=False 的情况下被过滤掉的,但是我的spider脚本如下:

这些被过滤掉的URL, 例如 hz.lianjia.com/chengjiao/xihu/ 明明是第一次取,却被filtered,看上去很像是由于和 hz.lianjia.com/chengjiao/ 重了而被去重的.

但是这两个URL明显是不一样的.不符合scrapy的去重规则呀, 请问老师这个URL被filtered的原因是什么?

1420

收起

正在回答

3回答

Scrapy打造搜索引擎 畅销4年的Python分布式爬虫课

- 参与学习 5831 人

- 解答问题 6293 个

带你彻底掌握Scrapy,用Django+Elasticsearch搭建搜索引擎

了解课程