请问老师,seq2seq模型怎么把输入的不定长句子转化成定长的向量啊?

是通过给encoder中的LSTM设置固定的神经元吗?

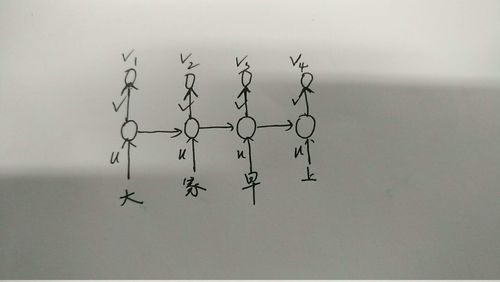

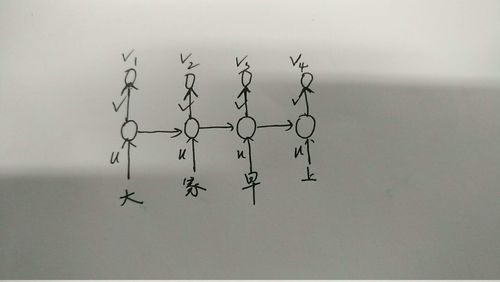

还有一个不明白的是,比如LSTM有四个神经元,那输入的句子假如是“大家早上好”,这里有五个字,那应该怎么输入啊?

像这样吗?那“好”怎么输入?

最后,是不是v1,v2,v3,v4这四个值就直接做一下层网络的输入啦?

1764

收起

是通过给encoder中的LSTM设置固定的神经元吗?

还有一个不明白的是,比如LSTM有四个神经元,那输入的句子假如是“大家早上好”,这里有五个字,那应该怎么输入啊?

像这样吗?那“好”怎么输入?

最后,是不是v1,v2,v3,v4这四个值就直接做一下层网络的输入啦?