关于代理ip无效的问题

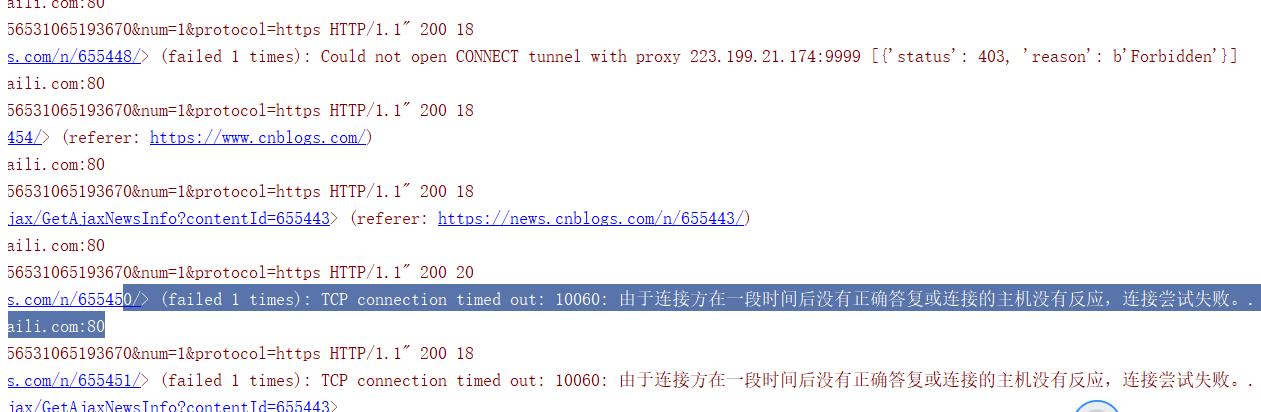

老师,您好今天在使用代理ip的时候发现ip有些会无效,所以我想请教一个问题,如果代理ip无效,那么使用这个ip的url会重新发起请求,获取新的ip吗,如果不会,是不是scrapy就跳过这个url执行下一个了。如果这样的话有什么好的解决办法吗?

1099

收起

正在回答 回答被采纳积分+3

1回答

Scrapy打造搜索引擎 畅销4年的Python分布式爬虫课

- 参与学习 5831 人

- 解答问题 6293 个

带你彻底掌握Scrapy,用Django+Elasticsearch搭建搜索引擎

了解课程