pycharm无法运行spark程序

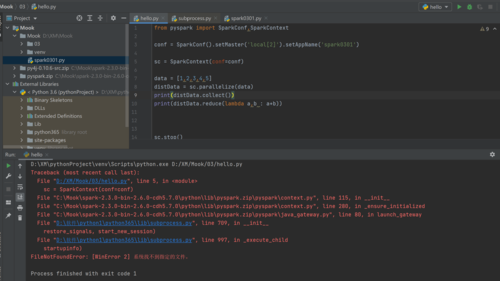

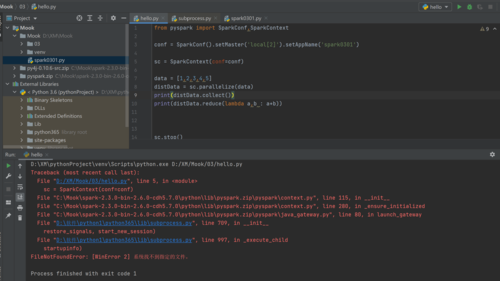

老师还需要您帮忙看一下这个,我之前spark2.3.0在本机上没有成功编译,显示没配置java_home,因为我这个新电脑没有安装任何java相关的东西。然后我把虚拟机里的编译好的包直接复制到本机上了 ,按照您要求配置好了pythonpath和sparkhome,也把您说的那两个包导进去了,但是运行程序还是报错,我不知道这个问题出在哪了?

老师还需要您帮忙看一下这个,我之前spark2.3.0在本机上没有成功编译,显示没配置java_home,因为我这个新电脑没有安装任何java相关的东西。然后我把虚拟机里的编译好的包直接复制到本机上了 ,按照您要求配置好了pythonpath和sparkhome,也把您说的那两个包导进去了,但是运行程序还是报错,我不知道这个问题出在哪了?

1683

收起

老师还需要您帮忙看一下这个,我之前spark2.3.0在本机上没有成功编译,显示没配置java_home,因为我这个新电脑没有安装任何java相关的东西。然后我把虚拟机里的编译好的包直接复制到本机上了 ,按照您要求配置好了pythonpath和sparkhome,也把您说的那两个包导进去了,但是运行程序还是报错,我不知道这个问题出在哪了?

老师还需要您帮忙看一下这个,我之前spark2.3.0在本机上没有成功编译,显示没配置java_home,因为我这个新电脑没有安装任何java相关的东西。然后我把虚拟机里的编译好的包直接复制到本机上了 ,按照您要求配置好了pythonpath和sparkhome,也把您说的那两个包导进去了,但是运行程序还是报错,我不知道这个问题出在哪了?