启动HDFS后,有NameNode、SecondaryNameNode,无DataNode。

问题:

验证HDFS是否启动成功,输入jps后

有NameNode、SecondaryNameNode,无DataNode。

查到的原因:

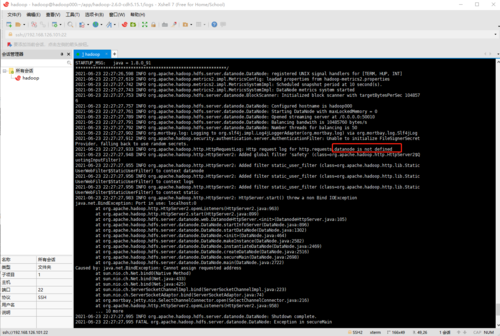

进入目录/home/hadoop/app/hadoop-2.6.0-cdh5.15.1/logs

输入:cat /home/hadoop/app/hadoop-2.6.0-cdh5.15.1/logs/hadoop-hadoop-datanode-hadoop000.log

查看日志,寻找原因:

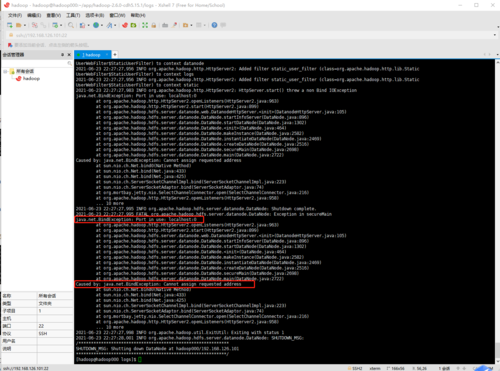

java.net.BindException: Port in use: localhost:0

Caused by: java.net.BindException: Cannot assign requested address

尝试的办法一:(运行后无效)

删除/home/hadoop/app下的tmp文件,再次执行初始化HDFS,再启动HDFS。

尝试的办法二:(运行后无效)

在目录下/home/hadoop/app/hadoop-2.6.0-cdh5.15.1/etc/hadoop

在hdfs-site.xml 中添加:

<property>

<name>dfs.datanode.address</name>

<value>0.0.0.0:50010</value>

</property>

再启动HDFS。

1144

收起