老问题could only be replicated to 0 nodes instead of minReplication (=1).

我是腾讯云买的服务器centOs 7

防火墙开启了这些端口 50070 50010 8020 3306 80 22

Datanode的启动日志全是INFO没有报错

Hdfs-site.xml配置

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

Core-site.xml的配置

<!--127.0.0.1 localhost 不能外部访问-->

<!--ip 不能开启-->

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://0.0.0.0:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/root/app/tmp</value>

</property>

</configuration>

Jps查看确实都有进程

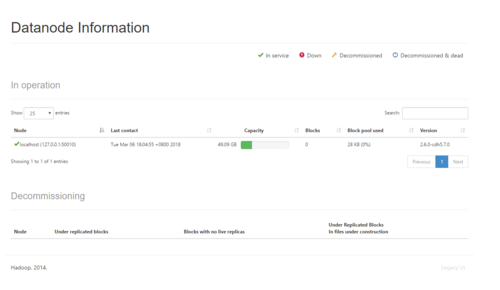

后台看也有

初始化namenode很多次了,有删除文件夹初始化的

就几乎百度上有的方法我都试过了,还是报错

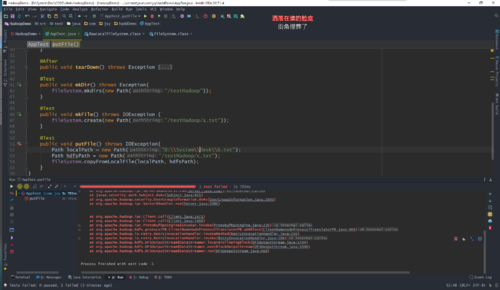

Java代码和老师的一样。还有没有什么办法

可以使用创建文件夹和文件,传文件就出问题了

2904

收起