nginx 缓存配置

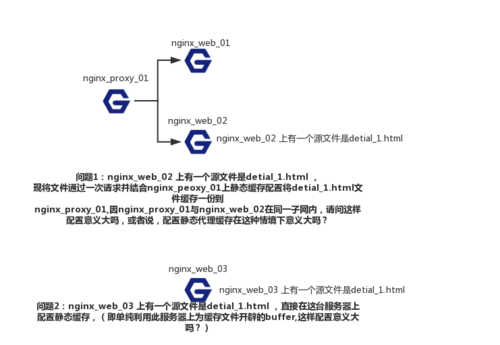

老师,您好,如果我 静态缓存 不配置在proxy 负载均衡服务器上,直接配置到web server(比如有个文件是detial.html,其文件位置就在 Nginx_web_server01 上),直接利用web_server 中开辟的静态资源缓冲buffer ,请问这样的配置会生效吗,或者说不将静态缓存配置到nginx_proxy01上,这样做意义大吗?

如下图所示:

1322

收起

正在回答

2回答

相似问题

登录后可查看更多问答,登录/注册