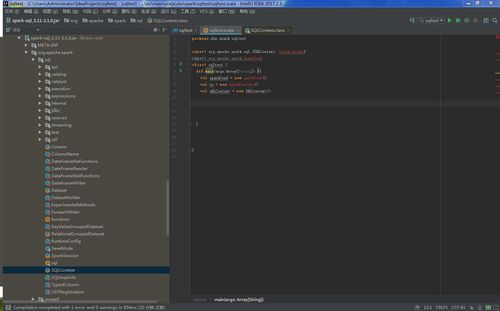

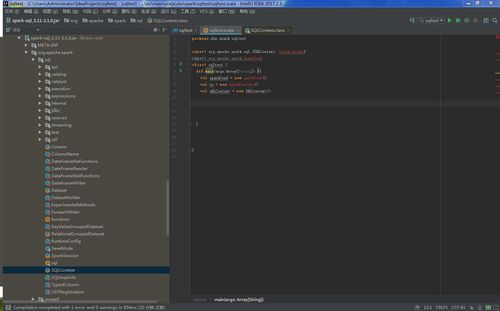

spark-sql_2.11-2.1.0.jar里面没有sparkContext sparkConf的类

spark-sql_2.11-2.1.0.jar里面没有sparkContext sparkConf的类

是我下的有问题 还是别的

2779

收起

spark-sql_2.11-2.1.0.jar里面没有sparkContext sparkConf的类

是我下的有问题 还是别的