crawl lagou不成功

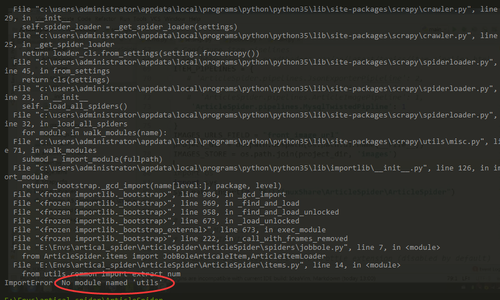

图一

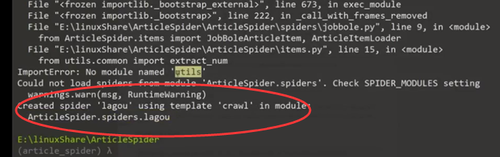

图二

图三(视频中)

1:首次>scrapy genspider -t crawl lagou www.lagou.com的时候就没有出现视频中成功一部分的情况

2:按照视频配置好图一后,依然如之前一样没有创建成功,图三一直没有在本机出现

3:会不会是因为python3.5的缘故呢?

测试了很久,不太明白原因,辛苦老师!

735

收起

正在回答

2回答

Scrapy打造搜索引擎 畅销4年的Python分布式爬虫课

- 参与学习 5758 人

- 解答问题 6263 个

带你彻底掌握Scrapy,用Django+Elasticsearch搭建搜索引擎

了解课程