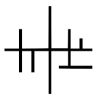

LayerNormalizaiton

【LayerNormalizaiton课程视频讲到:

在每一层layer的output上做Normalization,求均值和方差的,那么它就不是在batchsize的维度上做的;它和M没有关系,它是每一条样例的每一个layer的output上求解的均值和方差】

问题:求均值的时候不是M个数据求和再除以M求出的平均值么?还是说一条数据在这一层layer的不同的节点上的output值加在一起除以这一层的节点数?

(上一层不同的特征连接下一层不同的节点)

906

收起