京东数据爬不到

import requests

from lxml import html

def spider(sn):

"""爬取京东的图书数据"""

url = 'https://search.jd.com/Search?keyword={0}'.format(sn)

# html文档

html_doc = requests.get(url).text

print(html_doc)

if __name__ == '__main__':

spider('9787115428028')

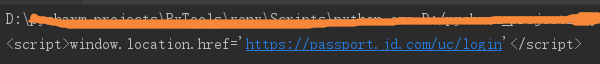

老师你好,京东网的数据爬不到了。请问有什么解决办法么?

1488

收起