Spark删除hive表后HDFS对应目录文件没有被删除

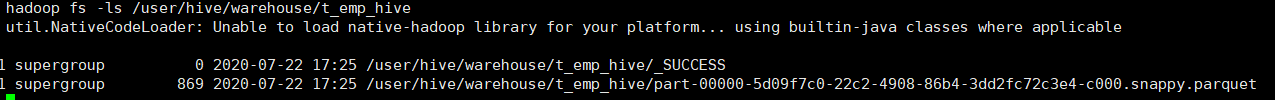

描述:使用SparkSQL往Hive中saveAsTable了一张表,查看表的desc,发现它是一个内部表,然后再beeline里面使用drop table将其删除,再次跑jar,抛出hdfs目录已存在异常。

问题:请问老师,记得之前的Hadoop课程中说过,如果是hive内部表,在删除内部表之后,hdfs存储的文件也应该被删除,为什么使用spark sql beeline删除表后,hdfs对应的文件仍然存在呢?

3295

收起