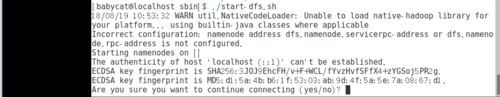

启动hadoop时候执行start-dfs.sh,报了图中的错误,这是什么原因?

相关配置文件内容如下:

core-site.xml

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs//:hadoop000:8020</value>

</property>

</configuration>

hadoop-env.sh

export JAVA_HOME=/home/babycat/app/jdk1.8.0_91

hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/babycat/app/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/babycat/app/tmp/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value></value>

</property>

</configuration>

marped-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>