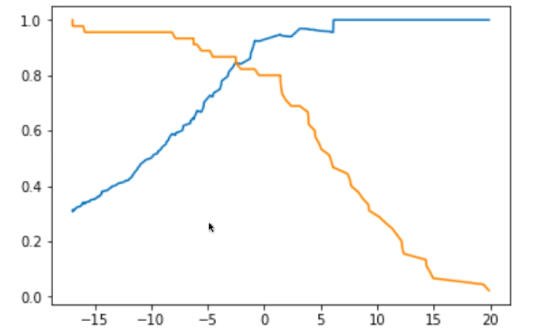

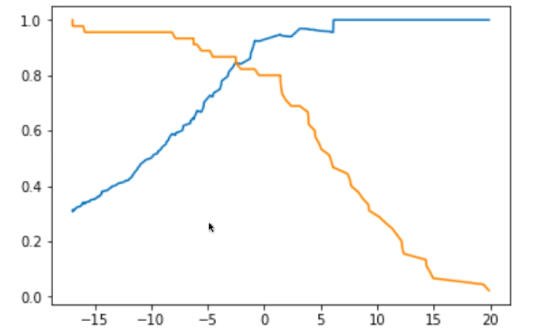

关于精准率和召回率的平衡点似乎都是在0左右

老师您好,本节课中的精准率和召回率的绘图可以看出平衡点都是在决策边界为0的时候

是否是因为逻辑回归在训练过程中使用的是>=0的决策边界,从而得到的theta值作用于测试数据集的时候也是使得其精准率和召回率在决策边界为0时达到平衡。

416

收起

老师您好,本节课中的精准率和召回率的绘图可以看出平衡点都是在决策边界为0的时候

是否是因为逻辑回归在训练过程中使用的是>=0的决策边界,从而得到的theta值作用于测试数据集的时候也是使得其精准率和召回率在决策边界为0时达到平衡。