map与mapPartitions内部实现的区别

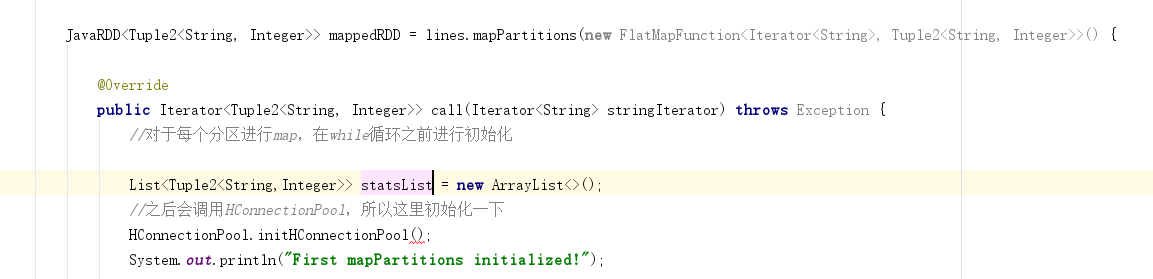

我在解析log时使用了mapPartitions,但是碰到了OOM问题,究其原因,我觉得是我使用的statList存放所有解析后的数据,这个list一直存在于内存中造成OOM。但是查了网上的说法,大家都说mapPartitions容易造成OOM,map本身则不会。我就想请问,spark在map的时候,1)将中间结果保存在哪里?2)为什么map的时候不容易OOM?3)我可不可以在mapPartitions里面使用map的一些内存管理的方式来避免OOM?

先在这里谢谢PK老师!

1048

收起