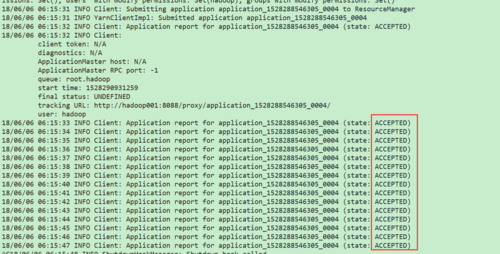

关于提交作业到Spark on yarn cluster时,出现如下问题???

一直处于state: ACCEPTED状态,我查了一下,是应为虚拟机内存(3G)的太小了嘛?我提交yarn client是可以正常运行的。

命令:

./bin/spark-submit \ --class org.apache.spark.examples.SparkPi \ --master yarn-cluster \ --executor-memory 1G \ --num-executors 1 \ /home/hadoop/app/spark-2.1.0-bin-2.6.0-cdh5.7.0/examples/jars/spark-examples_2.11-2.1.0.jar \ 4

1800

收起