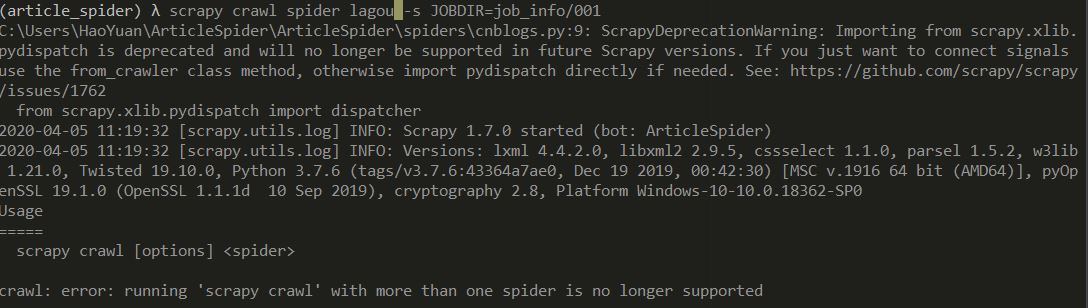

running 'scrapy crawl' with more than one spider is no longer supported

我按照老师开头的写法 scrapy crawl spider lagou -s JOBDIR=job_info/001

运行后报错,说我不能一次启动多个spider,我仔细看了看,发现我多打了一个spider。但是我想问问,如果要一次启动多个spider需要修改什么呢。

4016

收起

正在回答

1回答

Scrapy打造搜索引擎 畅销4年的Python分布式爬虫课

- 参与学习 5831 人

- 解答问题 6293 个

带你彻底掌握Scrapy,用Django+Elasticsearch搭建搜索引擎

了解课程