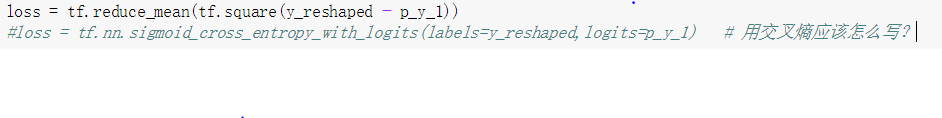

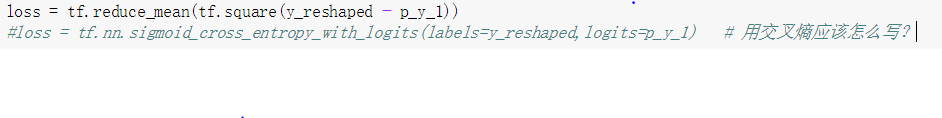

如果想用交叉熵函数改写这里的loss,应该怎么写?

上面的写法对吗?

另外,在这里使用平方差和交叉熵的loss,一般最后效果差别大吗?

如果是在多分类softmax里, 使用平方差和交叉熵,效果差别大吗?

728

收起

上面的写法对吗?

另外,在这里使用平方差和交叉熵的loss,一般最后效果差别大吗?

如果是在多分类softmax里, 使用平方差和交叉熵,效果差别大吗?