GridSearchCV中对训练数据集进行fit后,为什么就可以得到最佳超参数了?

我理解的比较模型accuray,需要先根据X_train,y_train数据fit,然后根据X_test, y_test数据来predict,才能得到score。然后比较每一组超参数的score.

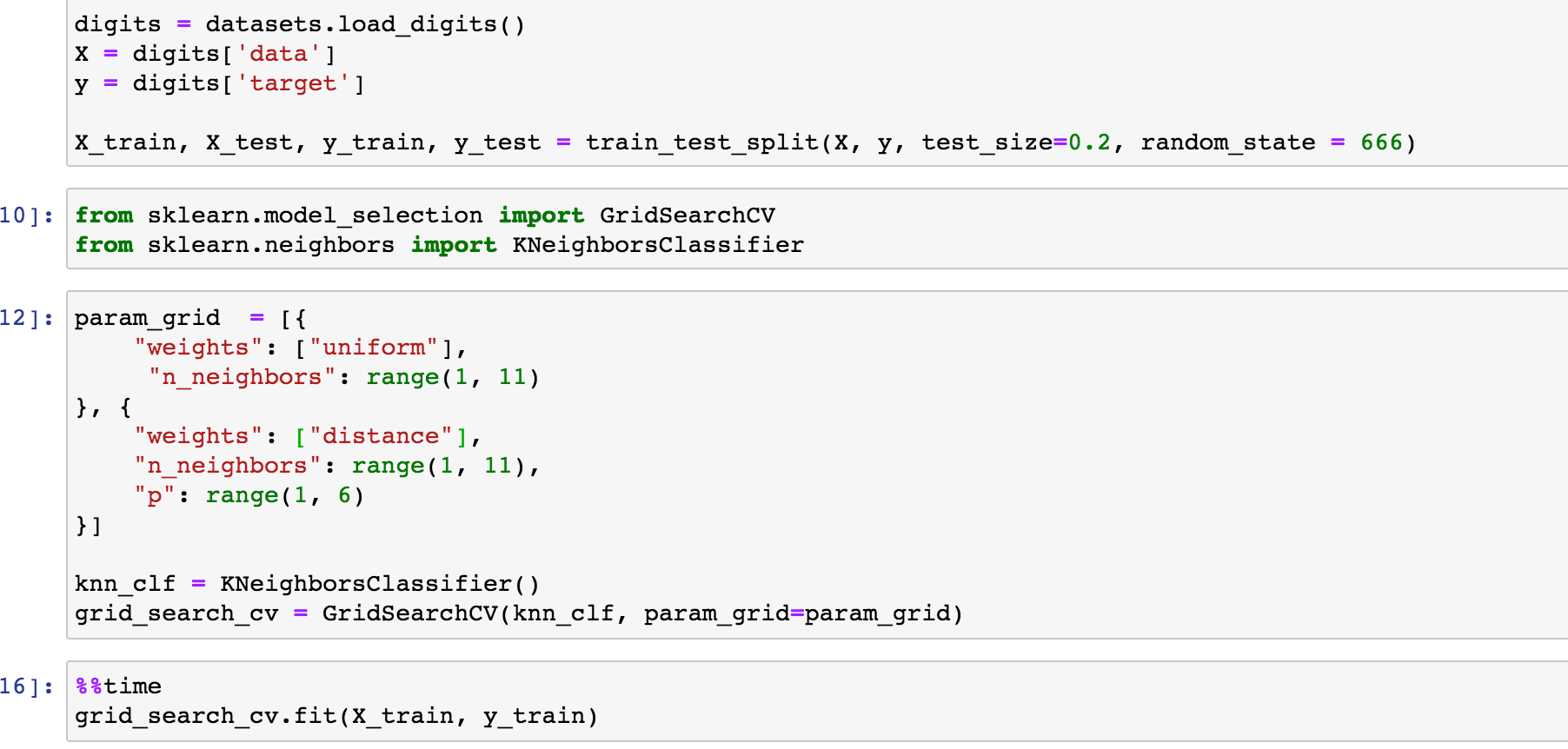

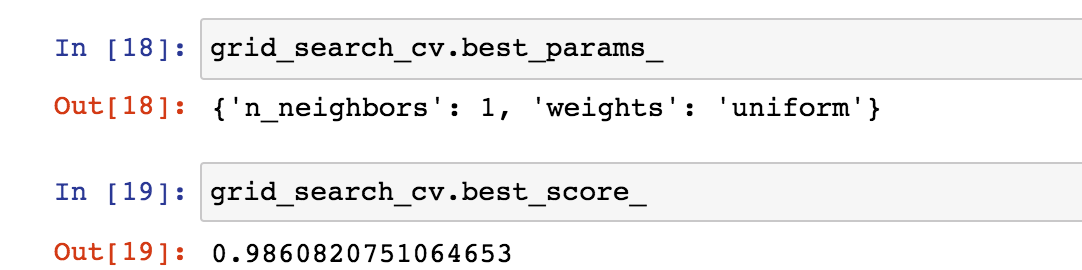

但是视频中只有一步fit.就得到了score.所以实际上这个fit内部包含度对数据集的train_test_split操作吗?

还有一个问题?为啥我使用scikit-learn中的网格搜索,结果很奇怪呢?

我把你的代码本地运行一遍,结果和上述一样。是scikit-learn的版本不一样吗?

2093

收起