【疑惑】决策边界的生成,SVM与多项式的关系

在消化波波老师这段话的时候,关于数据升维之后,将更可能线性可分这一点我有了比较深刻的认识,但在我深入思考后对于决策边界我产生了很多疑惑,我发现这部分我还不是很清楚。

疑惑(一)

以下是我在整理多项式进行逻辑回归时的思想历程,也是我疑惑的开始。

- 对X数据进行多项式(升维)

- 对X数据进行归一化(数据处理)

- 通过逻辑回归建立模型(建模)

- 通过模型预测,从而得出决策边界(可视化)

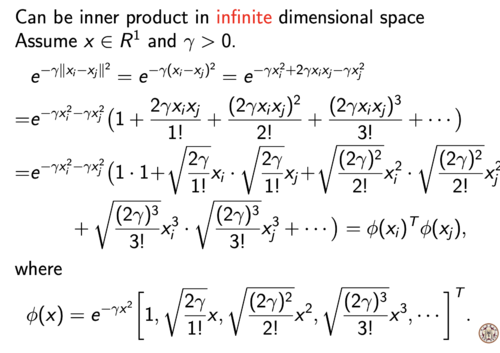

就多项式逻辑回归而言,决策边界的得到是在建立模型之后,通过模型的预测得到的,从多项式来看决策边界有接触到(通过高维数据建立的模型)高维数据(多项式后的X),但是SVM高斯核函数似乎并没有对数据进行升维,直接结合公式求结论,我的疑惑在于: 决策边界究竟是在二维层面画出一个很复杂的曲线(没升维),还是在高维简单的图像映射到低维的结果?

疑惑(二)

这个疑惑承接上文,和我上次问的PCA有些类似

假设(我更倾向于这个可能)决策边界是高位映射到低维的结果,在1维的数据X升维到2维,用一条线进行线性可分;2维数据X升到3维,是用一条线进行分割?还是用一个二维平面进行分割?

以此类推k维数据升到n维,是用n-1维进行分割还是?还是用一条直线进行分割?

疑惑(三)(不重要)

关于SVM中的核函数和多项式与决策边界的关系

二者在生成决策边界的过程中有何不同?

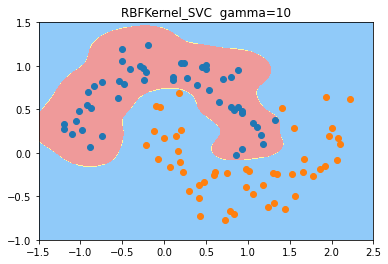

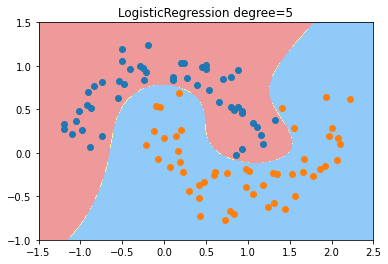

- 从结果来看,都生成了非线性的决策边界

- 从生成的结果来看,高斯核函数似乎呈圆形,多项式呈分割状。

#高斯核函数

Pipeline([

('std',StandardScaler()),

('svc',SVC(kernel='rbf',gamma=gamma))

])

#多项式

Pipeline([

('Poly',PolynomialFeatures(degree=degree)),

('standard',StandardScaler()),

('linearSVC',LinearSVC(C=C))

])

我不清楚二者之间的核心区别,亦或者区别不大?

934

收起

正在回答

1回答

相似问题

登录后可查看更多问答,登录/注册